小説『高慢と偏見』には、上流階級の傲慢なダーシー(Darcy)と、彼に対して偏見を抱くエリザベス(Elizabeth)が登場します。

AIモデルは、学習データに刻まれた偏りをそのまま抱え込み、自らはデータに映りきらない文脈を反映できない「偏見(バイアス)のかたまり」である、という指摘は長く続いてきました。

一方で、人間はデータには表れない微妙な文脈を直感で鋭く捉えることができる、AIには到底及ばない特別な知的能力を持つと考えられてきました。

しかし、チャン・ガンミョンの小説『先に来た未来』を読みながら、AIが決して追いつけないと信じてきた人間固有の知性こそ、むしろ私たちの「傲慢」ではないか――そんな疑問が湧いてきました。

(まず囲碁において)先に来た未来

「私は、未来はまず囲碁界に訪れたと思います。2016年から数年間、囲碁界で起こった出来事は、これからさまざまな業界でも起こるでしょう。人々がそこに価値があると信じ、何十年もの時間を費やして献身してきた仕事を、ある瞬間、突然に人工知能(AI)がより優れた形でやり遂げてしまうのです。」

―― 『先に来た未来』より

チャン・ガンミョン作家は、現役および元プロ棋士、そして囲碁の専門家たちに直接インタビューを行い、人工知能(AI)がある分野を完全に圧倒したとき、その世界にどのような変化が起こるのかを生き生きと伝えています。

「勝たねばならない。それが最も重要な問題であり、最大の欲望だった。

素晴らしい囲碁を打つとか、美しい囲碁を打つとか、『人間の囲碁』を打つことは、勝ってから考えるべきことだった。

多くのプロ棋士たちは、私が『人間の囲碁』や囲碁の芸術性について問いかけても、こう答えた。

『そんなことを考えている余裕はなかった。まずは生き残らなければならなかった』」

―― 『先に来た未来』より

イ・セドル九段が囲碁界を去りながら「私は囲碁を芸術だと学んできた。しかし人工知能(AI)が登場して以来、果たしてこれを芸術と呼べるのか疑問に思うようになった。」と語ったように、データ分析を仕事にしている私たちも、いつか同じような言葉を口にする日が来るのではないでしょうか。

以前の投稿(AI時代のBI)で、私はBI(ビジネスインテリジェンス)やデータアナリティクスの業務においては、複雑な現実世界の秩序を完全に映し出せないという「データの限界」があるため、社内データや分析ツールに自由にアクセスできるAIであっても、人間を超えるデータ分析を行うことは難しいと主張しました。

今回の投稿では、データから成果改善のインサイトを見つけ出し、それを分析レポートにまとめる作業において、人間がAIよりも優れている領域はこれからも残り続けるのか――改めて考えてみました。

データ分析レポート作成作業におけるアート(芸術性)

定量データを用いて与えられた問いに対する最適な解を自動的に導き出す作業は、いまや自動化されたアルゴリズムやベストプラクティスを組み込んだテンプレート型の分析でも十分に実現できる時代となりました。

データ分析を「P問題」と捉えたときのAnalytical AI Agentの役割

- 実務の観点から行われるほとんどのデータ分析作業は、その分析質問(例:「今月の〇〇指標はなぜ下がったのか?」)に対して、与えられたデータから最適解を、決定的古典コンピュータ(つまり量子コンピュータではなく、私たちの目の前にある一般的なPC=チューリングマシン)を用い、ポリノミアル時間(Polynomial Time=人間がある程度待てる時間)内で解ける Pクラス問題 とみなすことができます(参考:P≠NP問題)。

- つまり、定量的な成果差の主な要因をあらゆる観点とケースで分析して発見することは、不可能ではなく「時間がかかる作業」(O(n²)程度)なのです。

- しかし、与えられた質問に対して最適解を導くデータ分析の手順はまだ標準化されていません。そのため、AIの支援を受けて問題を解こうとする(いわゆる“vibe coding”)場合、自然言語で問いかけ・回答を繰り返す過程で大小の試行錯誤が伴います。

- 現状では、唯一絶対の答えが存在しない分析質問に答える最善の方法は、与えられた質問に対する最適な分析手法をテンプレート(モデル)として活用し、全てのケースで分析を行い(P問題なので可能)、そのうえで Business Impact(事業インパクト) と Complexity(実行可能性) を考慮しながらインサイトを導くことだと考えます。

- 私は、データ分析の文脈におけるAIの役割は「意思決定」そのものではなく、意思決定のためのレポートを生成すること にあると考えます。AIは「AではなくBを行えば、この指標は大きく改善します」といった積極的なアドバイスを提示できるべきであり、このような積極的助言こそが、当面の Analytical AI Agentのアクション であると考えます。

問題は、このように機械的に導き出された「最適解」が、事業の観点においても本当に最善の選択であるかどうかは、依然として人間の解釈と判断に委ねられている、という事実です。

データ分析に芸術的要素(洞察や直感)が存在するとか、事実(Fact)と同じくらいストーリーテリングが重要だと主張されるのは、このためです。

では、データに基づく意思決定(BI & Analytics)において、論理的な言葉で明快に説明したり、客観的に検証することが難しい芸術的側面(洞察力や直感)の役割は、囲碁のケースのように単なる幻想に過ぎず、最終的にはAIがより優れた解を導き出す領域になってしまうのでしょうか?

この問いに答えるために、ジェイソン・ウェイ(Jason Wei)が提示した「検証の非対称性(Asymmetry of Verification)」と「検証者の法則(Verifier’s Law)」をあわせて考察してみたいと思います。

AI発展の核心原理 ― 「検証の非対称性」と「検証者の法則」

「検証の非対称性」と「検証者の法則」

ジェイソン・ウェイ(Jason Wei)が提示した「検証の非対称性(Asymmetry of Verification)」の核心は、「ある問題は解くのは難しいが、その答えが正しいかどうかを検証するのは容易である」という点です。

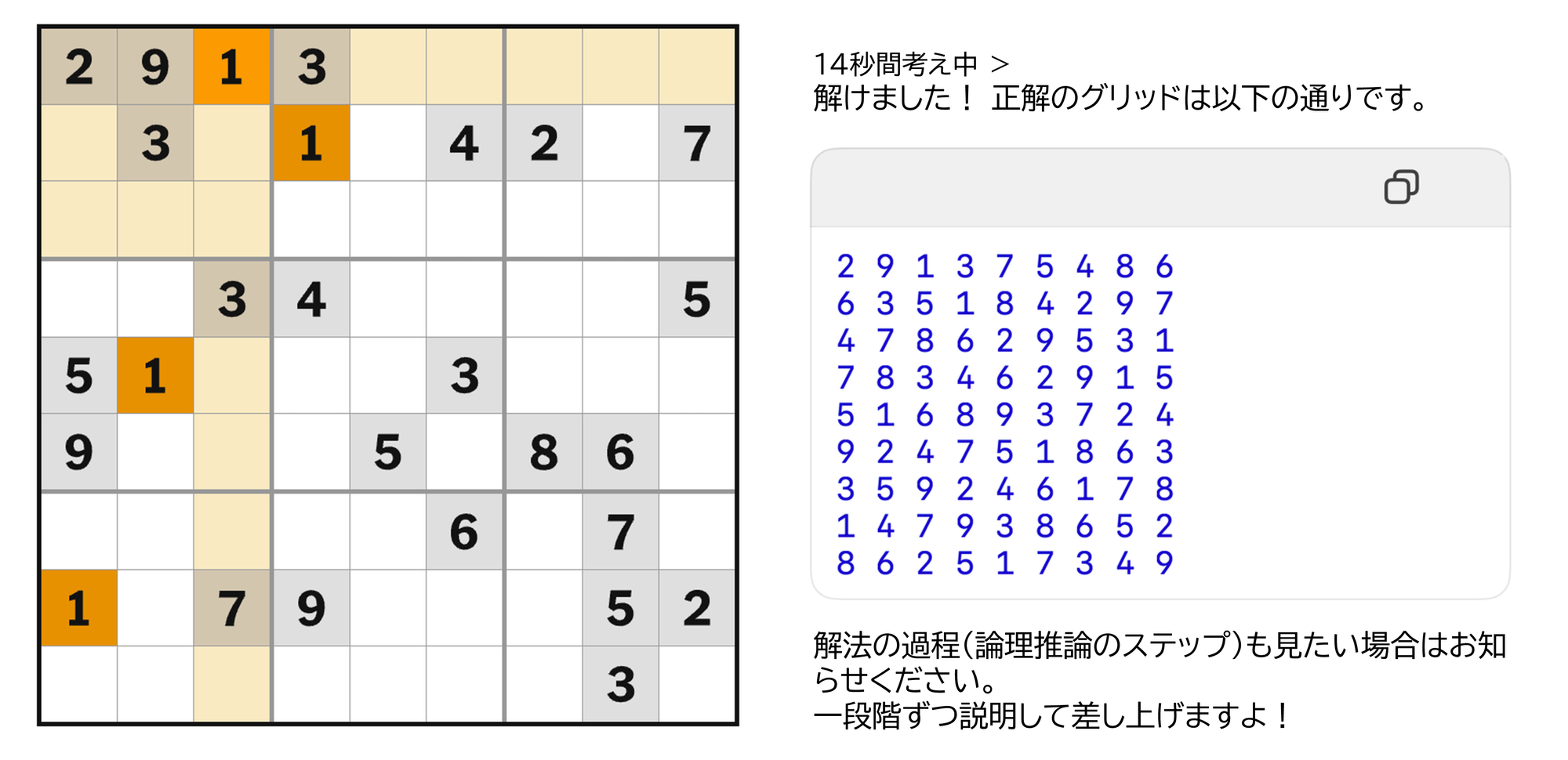

たとえば、数独やジグソーパズルは解くのに時間がかかりますが、完成した答えが正しいかどうかはすぐに判断できます。

逆に、問題を解くことよりも、その答えを検証することの方が難しい場合もあります。

ある文章に含まれるすべての内容をファクトチェックするには、その文章を書くのにかかった時間よりもはるかに長い時間が必要になることがあります。

「仕事をやり遂げること」よりも「その仕事が正しくできているかを検証すること」の方が難しい事例をさらに挙げると:

- Brandolini’s law(ブランドリーニの法則):ナンセンスを反駁するために必要なエネルギーは、そのナンセンスを口にするために必要なエネルギーの少なくとも10倍かかる。

- 特定の食事法(食習慣)が健康に有益であることを実際に証明するには、数年にわたる長期研究が必要となる。

検証者の法則(Verifier’s Law)

ウェイによれば「AIモデルの問題解決能力は、与えられた問題の検証可能性に比例する。」と言います。つまり、検証が可能なあらゆる作業は、結局AIが人間よりもうまくやり遂げることになる、ということです。

AIが得意(解決)できる作業の条件として、以下を挙げています。

- 客観的真実の存在(正解に全員が同意できる)

- 迅速な検証が可能(数回の試行で正解を確認できる)

- 大規模な検証が可能(複数の解答を同時に検証できる)

- ノイズが少ない(明確かつ一貫した基準が存在する)

- 連続的(Continuous)な評価が可能(解答の品質を順位やスコアで測定できる)

客観的に検証可能なものはすべてAIによって最適化・自動化されていくならば、

BI & Analytics業務の最終成果物である「分析レポート作成」も、最終的にはAIが担うことになるのでしょうか?

検証者の法則を基準に一緒に考えてみましょう。

データ分析レポートの真偽、客観的に検証できるのか?

データ分析レポートを検証者の法則の観点から見ると、検証可能な質問と、検証が難しい(Non-Verifiable)質問に分けられます。

検証が容易なケース

以下の質問は定量的データで明確に検証(Fact-Checking)できます。

- 経営指標モニタリング:売上はどれだけ増加したか?

- A/Bテスト結果の比較:どのキャンペーンの効果(クリック数)が高かったか?

検証が難しいケース

以下の質問は一つの正解を特定するのが難しく、提示された解答を基準に効果を検証するには長い時間がかかります。

- 事業戦略の立案:どの商品、どの顧客層に集中すべきか?

- 経営指標改善:売上減少に影響した要因や改善策は何か?

売上改善に関する質問への模範回答として、例えば以下のようなものが提示されるとします。

「主な要因は競合の大規模な値引きイベントと景気低迷による消費萎縮です。

売上改善のためには、差別化された製品ラインナップの強化と、オンラインチャネルでのプロモーション拡大が必要です。」

この回答に含まれる「競合の値引きイベントの時期と売上減少の時期の一致」はVerifiableです。しかし「競合の値引きが直接的な原因であったかどうか」や「提示された改善策」が、数ある分析の中で最も妥当か、実行可能か、実際に効果があるかどうかは、検証が難しいNon-Verifiableに該当します。

検証が難しい問題を検証可能にする方法

一見すると、企業における主要な質問(Why? How?)はAIにとって検証が難しいNon-Verifiable問題に見えます。

しかし、レポートに記載された内容に基づき意思決定を行ったとき、現実世界で生じた効果を検証するのではなく、レポートの主張を裏付けるデータやモデルに含まれる要素(ドメイン知識)の水準で検証すれば、状況は変わります。

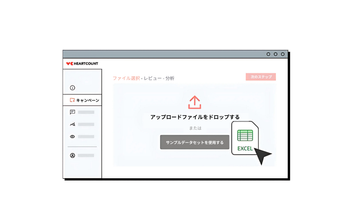

Why質問をWhat質問に置き換えること

Why? How? 型の質問も、客観的真実(正解)が存在し、その正解に対する基準があれば、Verifiable問題になり得るのです。

「なぜ?」という唯一の正解が存在しない質問を、「何がどれくらい?」という正解のある質問に置き換えることで、Non-Verifiableな問題をVerifiableな問題へと転換することができます。

(これはHEARTCOUNTが複雑な質問を処理する際のアプローチでもあります。)

- 「なぜ売上が落ちたのか?」というWhy質問を、「どの商品群の売上がどの地域で減少しているのか?」「最も大きく減少したのはどこか?」といったWhat質問に置き換えることで、全員が同意できる正解を持つ質問へと変換することができます。

- 「なぜ顧客ロイヤルティが低下したのか?」という質問を、「過去1年間で再購入が大幅に減少した下位20%(8th Percentile)の顧客の統計的特徴は何か?」に言い換えると、従来の統計的分析手法で答えられる質問となります。

ただし、正確に検証可能な正解が必ずしも私たちが求める正解と一致するとは限りません。

例えば「秋によく売れた防風ジャケットが冬には売れなかった」というのは明白な事実ですが、これはTBU(True, But Useless=正しいが役に立たない)であり、実行可能な答えにはなりません。

Business ImpactとComplexityを採点基準に据える

「検証者の法則」に従えば、質問に対する答えの品質を測定できる明確で一貫した採点基準が存在すれば、AIが複雑な質問にデータで答える作業を自動化することが可能になります。

良いデータ分析レポートには、確固たる事実に基づき、具体的で実行可能な戦略が含まれている必要があります。

その戦略は「実行のしやすさ(Low Complexity)」と「実行による期待効果(High Business Impact)」を満たさなければなりません。

例えば防風ジャケットのケースで言えば、当社の製品は秋には売れなかったが、競合他社の売上動向を確認したところ、防風ジャケットの全体市場の30%が秋に売れていた。

したがって我々も秋に防風ジャケットを販売すべきだ、という内容のレポートは、実行が容易で、実行による成果も期待できるものです。

もし分析結果に対してComplexityとBusiness Impactを基準に採点することができれば、「秋に売れた防風ジャケットが冬には売れなかった。では冬にも積極的に販売すべきか?」ではなく、「需要は限定的だが潜在需要が存在する秋シーズンにおいても、防風ジャケットを販売すべき」という洞察を提示できるでしょう。

(この内容に関する実際の研究結果は、今後ウェビナーにて共有予定です。)

ほろ苦い教訓(The Bitter Lesson)

「ゴミ箱モデル(Garbage Can Model)」と呼ばれる古典的な組織理論があります。

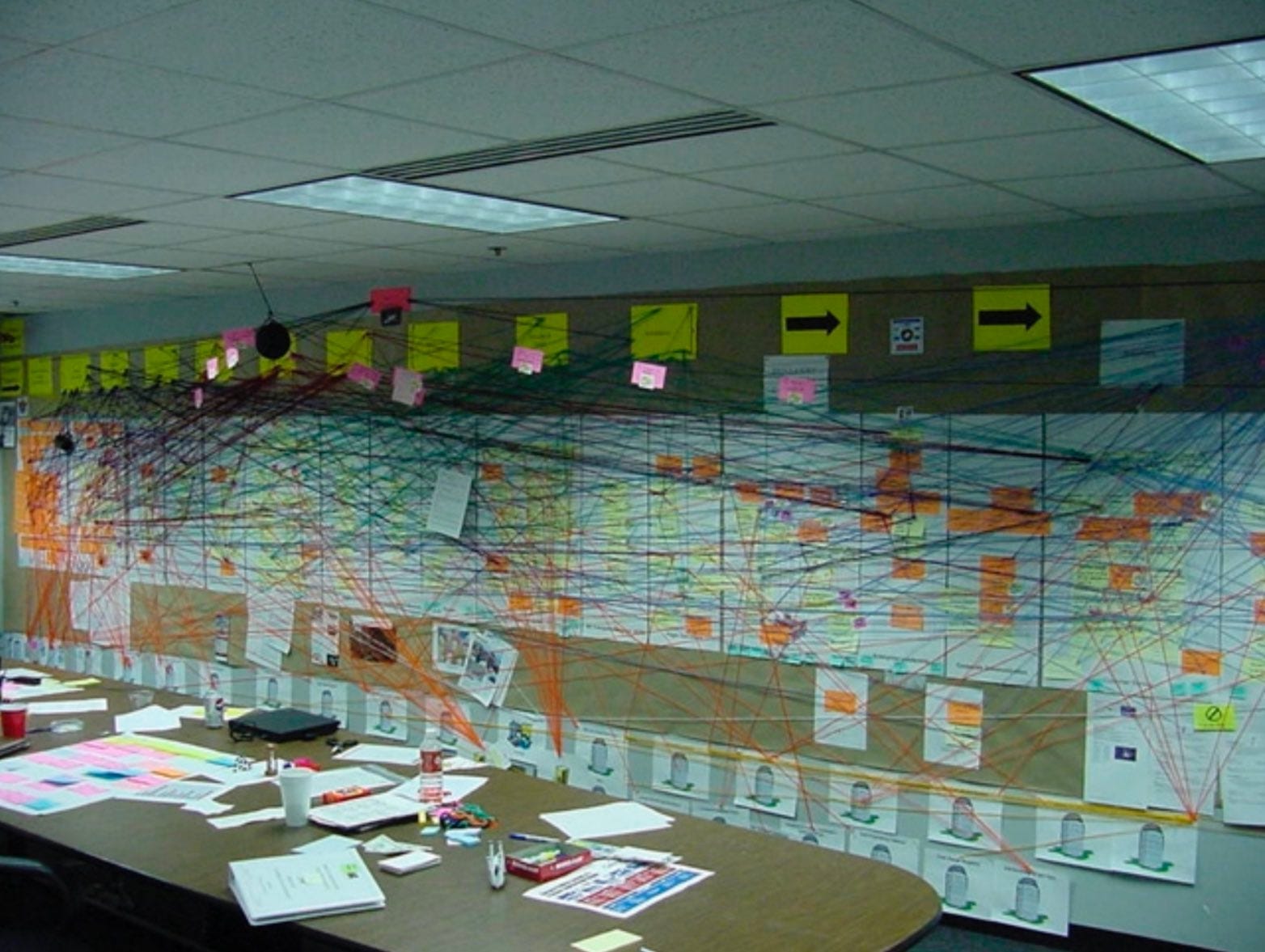

この理論は、組織における意思決定は、問題と提示された解決策、そしてさまざまな利害関係を持つ意思決定者たちが、まるでゴミ箱の中でごちゃ混ぜになったような状態の中で、偶発的に下されるものだと説明します。

組織にはシステムやプロセスが存在しますが、それは精緻な実験や検証の成果ではなく、人々の間のほどよい妥協や慣習の積み重ねによって形成された、暗黙的で恣意的な不完全な仕組みである可能性が高いと考えます。

CEOは、自身の組織の運営が自分の手に負えるものではないだけでなく、

自分がそれを把握しているという認識すら幻想に過ぎなかったと明かしました。(出典リンク)

そのため、企業内の主要プロセスにAIを適用するのが難しい理由として、

自動化の前提となる「明確に定義されたルールやプロセス」がそもそも存在しないからだ、とも言われます。

今年チューリング賞を受賞したリチャード・サットン(Richard Sutton)教授は、「Bitter Lesson」という文章の中で、

複雑な問題解決のために人間の知識を丁寧に注入するよりも、膨大な計算能力を持つ機械に「探索(search)」と「学習(learning)」のプロセスを任せ、外部世界の複雑な構造を自ら獲得させる方が効果的だと述べています。

それはちょうど、アルファ碁ゼロが人間の棋譜を参照せず、わずか40日間で約2900万局もの自己対局を重ねた結果、従来のアルファ碁を圧倒したようなものです。

最近では、多くの企業の関心が AIエージェント(AI Agent) に集まっています。

例えば Manus は、開発者が精巧に設計したシステムプロンプトと手順に従って、与えられた複雑な問題に対する「to-doリスト」を生成し作動する、と言われています。これはまさにBitter Lessonが警告したアプローチそのものです。

一方で ChatGPT Agent は、システムプロンプトによって問題解決プロセスの知識を注入するのではなく、最終成果物の品質を基準に強化学習(RL)するよう設計されています。実際に私自身が直接確認したわけではありませんが、一部のタスクではManusよりも高品質な成果物を出すとも言われています。

このことは、組織のあちこちに張り巡らされた数多くの非公式なワークフローや文書化されていない慣習が、実はそれほど重要ではないことを示唆しています。

AIに必要なのは、十分な事例と「良い成果物を見分ける目」だけなのかもしれません。

―― 苦い教訓(Bitter Lesson)が、なぜか甘美にすら感じられるのです。

不確実性(Uncertainty)と不確定性(Indeterminacy)

「データ分析レポートの品質を検証できる客観的な基準が存在し得るのか?」という問いに対する答えは、私たちが「良いデータ分析レポート」をどう定義するかにかかっています。

測定・収集可能なすべてのデータを活用して確率的な判断を行うことで、事業における不確実性を減らし、運や勘に頼った意思決定よりも、長期的により大きく持続的な成果を得ることができます。

データから発見した事実に具体的な文脈を付与し、より良い意思決定につながる選択肢を提示すること――これが「良いレポート」の条件です。

一方で、事業上の重要な意思決定とは、多くの場合、過去の記録から学べるものがほとんどなく(データが乏しく、結果のフィードバックも遅い)、毎回新しく、本質的に予測不可能な「不確定性」を伴うものです。

そのため、その品質を事前に検証できる分析レポートなど存在し得ません。

言い換えれば:

- レポートの「内容」そのものを基準にするのか、

- レポート内容に基づいて行動したときの「実際の結果」を基準にするのか、

二通りの考え方があると言えるでしょう。

しかし、2を基準にしてしまう限り、残念ながら「良いデータ分析レポート」というものは存在し得ないのです。

Facts Are Sacred

『Facts Are Sacred』は、イギリスの新聞ガーディアン(The Guardian)のデータジャーナリズムチームの経験と哲学をまとめた書籍です。

そのタイトルは、ガーディアンの創立精神である「事実は神聖である(Facts Are Sacred)」という原則から取られたものだといいます。

この本では、ジャーナリズムの本質とは、事実を尊重し、意見と徹底的に切り離して透明に伝えることだと語られています。

すべてが相互に影響し合い、自分の選択の結果を客観的に検証することがそもそも不可能な不確定な世界であるならば――

意思決定の「結果」ではなく、その「プロセス」こそが検証と改善の対象となるはずです。

そうである以上、企業にとって最も貴重(Sacred)なものは、検証可能なデータから発見された事実(Factual Finding)なのだと感じます。

そして、発生した事実の中から、収益に役立つものを適切に提示することこそ、AIデータ分析ツールの役割だと思います。

傲慢な人間と、偏りを抱えたAIが、幸せに、そして長く共に生きていけますように。

「私は序盤で石がない場面では、どこに打てばいいのか全く分からなかったんです。感覚もあまり良くなかったです。

でも、人工知能(AI)で勉強すると序盤の学習がとても簡単になるんです。

だから、自分の大きな弱点だった部分がかなり補われました。

その結果、成績も大きく向上しました。」

―― 『先に来た未来』より、チェ・ジョン九段(崔精9段)のインタビュー引用

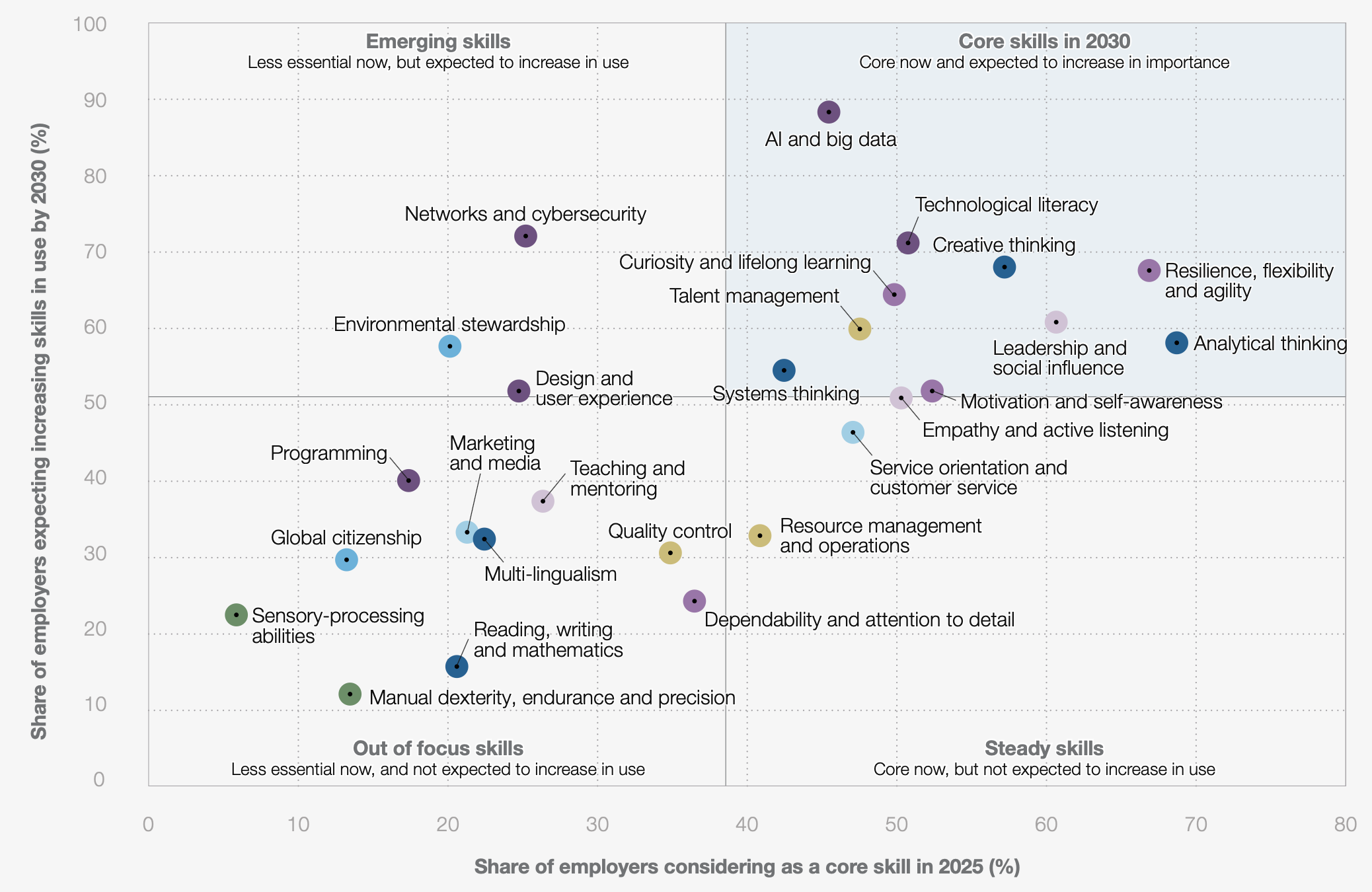

付録:分析的思考(Analytical Thinking)

分析的思考とは、複雑な問題を構成要素に分解し、それぞれの要素間の関係やパターンを理解したうえで、データや事実に基づき合理的かつ科学的に意思決定を行う思考法を指します。

分析的思考のスキルによって、私たちは直感ではなく具体的な根拠に基づいた意思決定を行えるようになります。

世界経済フォーラムが発刊した『The Future of Jobs Report 2025』でも、分析的思考は重要な未来のスキルの一つとして挙げられています。

(以下は同レポートからの抜粋図と原本PDF)

WEF_Future_of_Jobs_Report_2025.pdf • 18 MB

私は分析的思考が必要な理由を、「人間がデータを用いた分析をAIよりもうまくできるから」だとは考えていません。

むしろ、AIが提示する解答とその根拠が、現実において実際にどのような効果を生むのかを検証することは、多くの場合容易ではありません。

だからこそ、提示された内容を正確に理解し解釈し、より良い最終的な意思決定につなげるために必要なスキルであり、重要な資質なのだと思います。

HEARTCOUNTは、複雑なデータ分析を「答えのある問題」に変換し、 あなたのビジネスインサイトのためのレポートを生成します。

最適な分析プロセスを備えたシナリオにご関心がある方は、ぜひ今すぐHEARTCOUNTをお試しください。

おすすめの参考記事